Tag: Сделал

новости и заметки по data engineering и data science, rss читалка, python, django, web parser, cron, docker

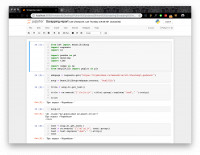

с помощью Python извлечь данные из базы данных MySQL Эгеи и положить в .csv или Google Sheets

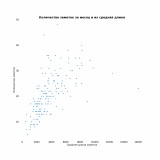

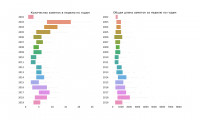

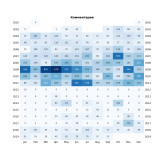

В двух предыдущих заметках я рассказал, как собирал данные и приводил базовый анализ на самые-самые заметки

На винде можно было тыкнуть в поле времени и появлялся календарь на месяц. На маке мне этого не хватает

Провел его через несколько итераций с замечаниями «технического» и «арт-директора» — кураторов курса

Earlier

Ctrl + ↓